「AIによる分断、AIによる包摂」笹原和俊

笹原和俊

東京科学大学 環境・社会理工学院 教授

1976年福島県生まれ。2005年東京大学大学院総合文化研究科修了。博士(学術)。現在、東京科学大学環境・社会理工学院教授。専門は計算社会科学。主著に「フェイクニュースを科学する 拡散するデマ、陰謀論、プロパガンダのしくみ」(化学同人)、「ディープフェイクの衝撃 AI技術がもたらす破壊と創造」(PHP研究所)がある。

はじめに

スマートニュース メディア研究所が主催する「AIと人間の「あいだ」を考える研究会」では、AIと人間、メディア、そして社会との関係を多面的に捉え、テクノロジーと共に生きる未来のあり方を探求してきた。AIが私たちの暮らしに急速に入り込むなか、利便性の向上と引き換えに、人間社会の基盤に新たな緊張や歪みが生じつつある。とりわけ生成AIの登場は、情報の生成・流通の仕組みを根本から変え、個人や集団の認識や行動に深い影響を及ぼしている。

SNSやニュースアプリでは、AIがユーザーの閲覧履歴や反応に基づき、関心に沿ったコンテンツを優先的に提示する。これは情報収集を効率化する一方で、似たような価値観や意見に偏った「エコーチェンバー」を形成しやすくする。また、「ディープフェイク」(AIによって生成された偽の画像、音声、映像)がSNS上で拡散され、政治的不安や市場への影響を引き起こす事例も確認されている。実際、2023年には米国防総省近辺の爆発を示す偽画像が拡散され、一時的にドルが急落した。

一方、こうしたリスクを軽減し、AIを活用して多様な人々のあいだに対話や理解の機会を生み出そうとする試みも始まっている。「ナッジ」(人々が自然に望ましい行動を選ぶよう、選択肢や環境を工夫して促す方法)の活用や、AIエージェント(自律的に最適な行動を選び、タスクを自動で実行するAI)と人との協働による集合知の促進は、その具体例である。

本稿では、研究会の議論を踏まえつつ、AIが現代社会にもたらす「分断」と「包摂」の両側面に注目し、計算社会科学の視点から考察を行う。

AIがもたらす分断

SNSは本来、人と人をつなぎ、情報共有を促進するためのツールとして発展してきた。しかし現実には、同じ意見や価値観を持つ人どうしが集まり、異なる視点に触れにくいエコーチェンバーが生まれやすい環境となっている。この傾向は、AIによる推薦アルゴリズムがユーザーの関心に沿った情報ばかりを優先的に提示することで、さらに加速されている。特に、感情を強く刺激する過激な投稿が表示されやすく、情報空間の閉鎖性を深めている。

こうした閉じた情報環境では、フェイクニュースや陰謀論、プロパガンダやヘイトスピーチが拡散されやすくなる。たとえば、LGBTや宗教的少数派をめぐって道徳的分断が生じている状況下では、異なる価値観が共通の土台を欠いたまま対立し、対話が成り立たない状況が可視化されている[1, 2]。さらにこの分断の広がりは、人間だけでなく、AIによっても加速されている。2020年の米大統領選では、悪質な「ボット」(自動で投稿・再投稿するアカウント)が陰謀論や扇情的なメッセージを大量に投稿し、偽・誤情報が大量拡散されたことが明らかになっている[3]。

こうした分断構造の背景には、SNSプラットフォームのビジネスモデル、すなわち「アテンションエコノミー(注意経済)」がある。多くのSNSは、ユーザーの注意を長く引きつけることで広告収益を得ており、その設計は怒りや驚きといった強い感情を喚起する投稿を優遇するようになっている。加えて、人間には信じたい情報を信じる「確証バイアス」があり、「いいね」やシェアといった承認指標がその心理をさらに強化する。このように、ユーザーの認知と感情、そしてプラットフォームの設計が相互に作用することで、過激な投稿が次々と広がっていく悪循環が生じている。

その結果、 SNS上で情報の偏在が進むことにより、社会の分断を助長する危険性が指摘されている。この問題は、単なる技術的課題ではなく、SNSの設計思想や経済構造にも深く根ざした複雑な問題であり、容易に解決できるものではない。

反乱する警告ラベルがもたらす逆効果

SNS上のフェイクニュース問題において、近年特に注目されているのがディープフェイクである。技術の進歩により、著名人になりすました発言や、実在しない出来事を映した映像が本物そっくりに生成され、不特定多数に拡散される事例が増えている。視覚情報は人間の認知に強く作用するため、ディープフェイクは文字だけのフェイクニュース以上に受け手を欺きやすく、新たな社会的リスクとして懸念されている。

では、ディープフェイクの拡散をどう防ぐべきか。その対策の一つとしてよく使われる手法が警告ラベルの表示である。これはAIがコンテンツを解析し、「この動画は偽物の可能性があります」といった注意喚起を視聴者に示す仕組みで、誤情報への信頼を下げる効果が期待されている。

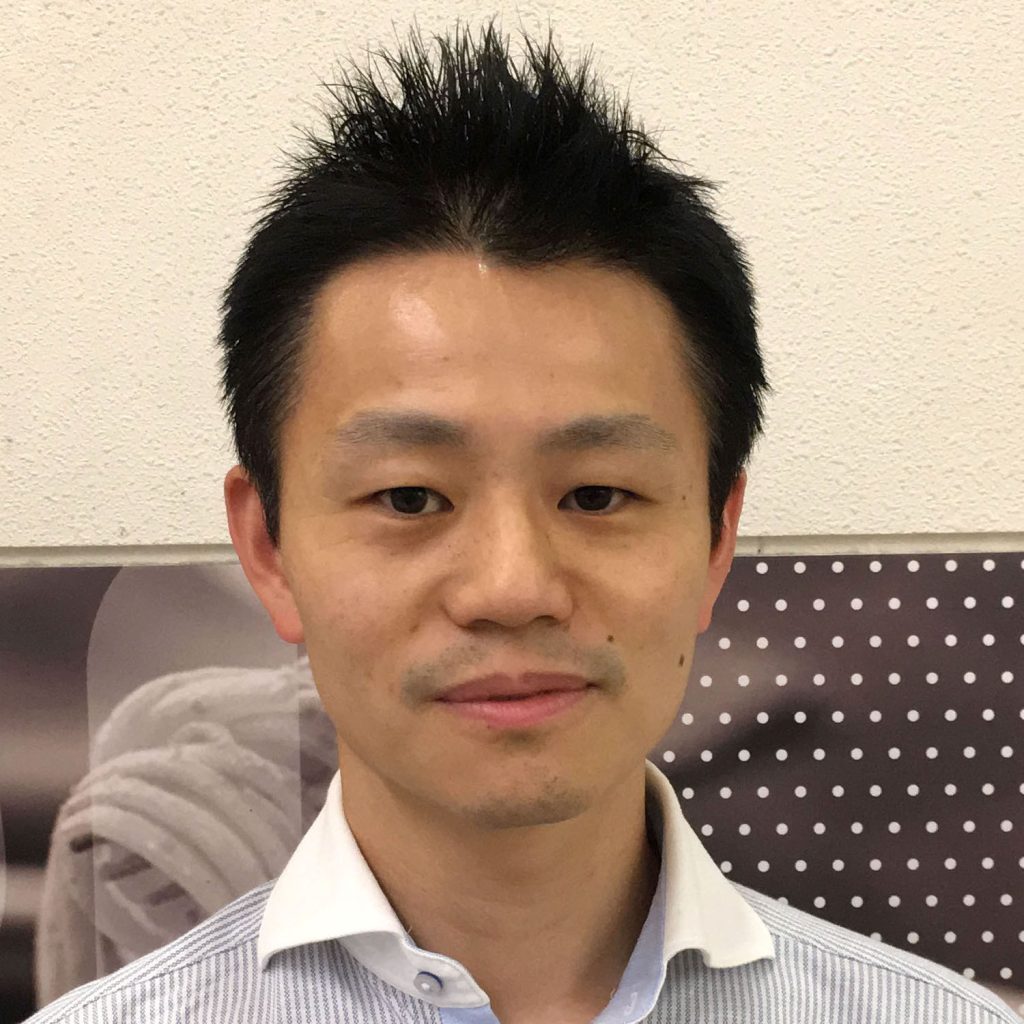

実際、警告ラベルの効果に関しては興味深い研究がある。著者の研究グループは、ディープフェイク動画に対する警告の表示タイミングと表示頻度を操作したオンライン実験を実施した[3]。その結果、動画の視聴中に一度だけ警告を表示すると、視聴者の「この動画をSNSで共有したい」という意欲が大きく低下することが明らかになった(図1aの真ん中の棒グラフ)。視聴後に警告を表示するだけでは効果がなかった(図1aの右の棒グラフ)。

一方、複数の動画を視聴中に繰り返し警告を表示すると、ユーザーが警告に慣れてしまい、抑止効果がなくなることや(図1bの真ん中の棒グラフ)、「警告された」という事実への反発から、かえって共有意欲が高まる逆効果が観察された(図1bの右の棒グラフ)。

これらの結果が示すのは、警告ラベルの頻度やタイミングにより共有意欲が影響を受けるという点、そして視聴中の適切なタイミングで短く注意を促すのが最も効果的な警告ラベルとなる点である。

このことは、AIの技術的精度と社会的受容性とのあいだに本質的な乖離が存在していることを示唆している。たとえ高度なAIがディープフェイクを的確に検出し、ユーザーに警告を発したとしても、その情報が素直に受け入れられ、実際の行動変化につながるとは限らないのである。ディープフェイクによる社会的リスクを抑制するには、技術的対策に加え、人とAIのあいだに信頼を築く新たな方策が必要である。

図1 警告ラベルの効果。aとbは警告ラベルの表示回数の違い。縦軸は動画を共有する(しない)を選んだ被験者の割合、横軸は警告タイミングの違い(「警告なし」「視聴中の警告」「視聴後の警告」)。

AIによる包摂の可能性

これまで見てきたように、AIの普及は、エコーチェンバーやフェイクニュースの拡散を通じて社会の分断を深める危険性を伴う。しかしその一方でAIを活用して、包摂的な社会を実現しようとする試みも始まっている。特に、生成AIや対話型AIエージェントを用いて、人々の認知や行動にポジティブな変容を促し、分断を乗り越えるための研究が始まっている。

ここで鍵となるのが、「ナッジ」(前述)と「多様性の確保」という2つの視点である。AIエージェントは、ユーザーの関心や性格傾向を学習しながら、健全なコミュニケーションを後押しするような投稿や提案を行うことで、人々をさりげなくより良い方向へと導くことが可能である。

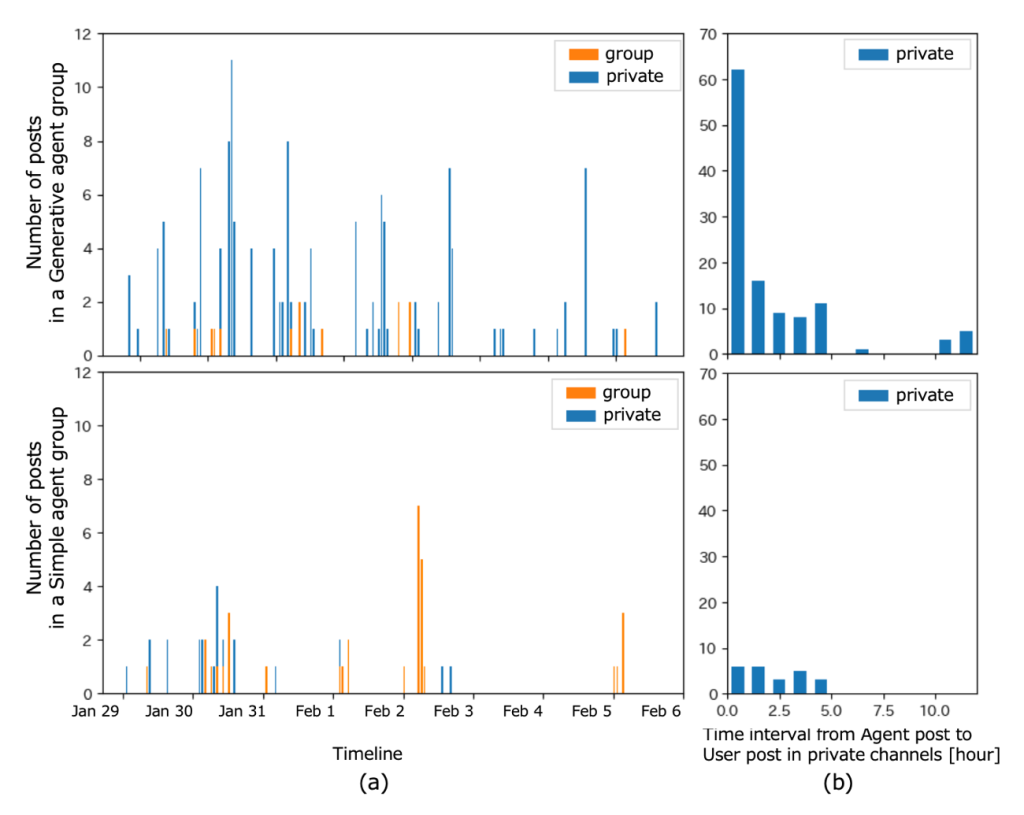

たとえば、議論が一方向に偏っていると判断された場合、AIが意図的に少し異なる視点の情報を提示し、議論のバランスを取る。また、対立するグループ間に共通の話題を提供することで、対話の糸口をつくることもできる。実際に、著者らが行ったオンライン実験では、生成AIエージェントをチャットボットとしてSNS上の会話に参加させたところ、会話が活性化し、ユーザー間の交流が円滑になることが確認された[4]。図2がその一例で、生成AIエージェントを含むグループの方(図2上段)が、ステレオタイプなエージェントを含むグループ(図2下段)より、会話の頻度と多様性の面で顕著に活発であった。初対面の集団においても、AIが雑談の話題を提供したり、議論の途切れをつなぐことで、短時間で打ち解け、協働作業へとスムーズに移行する様子が観察された。

注目すべきは、AIが異なるユーザー間の情報を橋渡しする媒介者になり得る点である。たとえば、グループで交わされた有益なアイデアや知見をAIが抽出し、これまで接点のなかったユーザーの間に「弱い紐帯(Weak Ties)」が生まれる。このような「つながり」は、閉じたエコーチェンバーの構造を緩和し、視野の拡張と多様な意見交換を促す基盤となる。

多様な知見が交差することで、集合知が引き出され、より創造的かつ建設的な議論や意思決定が可能になる。事実、著者らの実験においても、生成AIエージェントの導入によって参加者間の交流が活性化し、新たなアイデアの創出が促進されたことが明らかになっている。

もちろん、AIが提供する情報や提案が常に正確かつ中立とは限らない。偏りや誤りが完全に排除されることはなく、その限界を前提とした上での活用が求められる。だからこそ重要なのは、AIを万能な存在としてではなく、人と人との関係性を補完・促進する「媒介者」として適切に位置づける視点である。AIを、人間社会の多様性と相互理解を支えるツールとして捉え、透明性・公平性などの性能向上に加えて、ユーザーリテラシーや制度設計との連携に基づいた、包摂社会の実現に役立てる取り組みが必要である。

図2 生成AIエージェントグループ(上)と単純エージェントグループ(下)の投稿ダイナミクス。(a) 1時間ごとの投稿タイムライン(b)プライベート・チャンネルに投稿する間隔。

まとめ

本稿では「AIによる分断、AIによる包摂」というテーマのもと、AIやSNSが現代社会にもたらす影響について整理し、計算社会科学の視点から整理・考察を行った。SNSは、もともと人と人をつなぐために発展してきた技術であるが、その設計と運用次第では、むしろ分断を深める要因ともなりうる。情報の偏在、感情的な投稿の増幅、そしてエコーチェンバーの形成は、AIによる推薦システムや拡散アルゴリズムによってさらに加速され、社会の亀裂を顕在化させている。

とりわけ、ディープフェイクなどの生成AIが進化する中で、AIが生み出す偽・誤情報が現実の出来事と区別しにくくなっており、そのリスクをどう抑えるかが大きな課題となっている。この問題の根底には、AIの技術的な精度と、社会的な信頼・受容性とのあいだに生じている乖離がある。いかに高度な技術で偽・誤情報を検出できたとしても、ユーザーがそれを受け入れ、行動変容につなげるとは限らない。そのため、AIによる対策だけでなく、ユーザー側の情報リテラシーの向上や、プラットフォーム全体の土台となる設計思想やビジネスモデルの転換が不可欠である。

一方で、同じAI技術を包摂的な方向に活かす試みも続けられている。生成AIや対話型エージェントを通じて、異なる立場や背景を持つ人々の間に対話の機会を生み出し、共感や協働を促すことができる。ナッジや情報の橋渡しによってエコーチェンバーを緩和し、多様な知を結びつけることで、集合知の創出や創造的な問題解決にもつながる。著者らの実験でも、生成AIエージェントの導入によって会話が活性化し、新たな関係性が構築される過程が観察されている。

重要なのは、 AIの利用が社会のより良い発展に直結する訳ではないという点である。AIはあくまで中立なツールであり、それを分断の方向に使うか、包摂の方向に活かすかは、私たち人間の選択と設計に委ねられている。開発者や企業には、単に効率や収益性を追求するのではなく、社会の多様性と調和を支える設計思想が求められる。また、利用者一人ひとりも、AIに依存するのではなく、その影響を正しく理解し批判的に情報と向き合う姿勢が不可欠である。

AIがもたらす未来が、分断に傾くのか、それとも包摂へと向かうのか。その選択は、私たち自身に委ねられている。すでに包摂に向けた知見と実践は積み重ねられつつある。これらを生かし、AIと共に歩む社会のかたちを築いていくことが、これからの私たちに求められている。

[1]笹原和俊, 杜宝発. ソーシャルメディアにおける道徳的分断:LGBTツイートの事例. 社会情報学 8, pp. 65–77, 2019.

[2]Ghasiya, P. and K. Sasahara, K. Rapid Sharing of Islamophobic Hate on Facebook: The Case of the Tablighi Jamaat Controversy, Social Media + Society 8(4), 2022

[3]Xu, W. and Sasahara, K. Characterizing the roles of bots on Twitter during the COVID-19 infodemic. J Comput Soc Sc 5, pp. 591–609, 2022.

[4]Chen, J., Sugano, B. T., Frik, A., Nguyen, H. H., Yamagishi, J., Echizen, I., Igarashi, T., and Sasahara, K. Paradoxical effects of warning timing and frequency on dubious video sharing intentions, 2025. https://doi.org/10.31219/osf.io/xzjvg_v1

[5]M. Tanaka, A. Naito, K. Onoue, and K. Sasahara, How Generative Agents Transform Team-Building Dynamics on Online Communication Platforms, 10th International Conference on Computational Social Science (IC2S2), 2024(ポスター発表)