「デジタルプラットフォームと偽情報」笹原 和俊

笹原和俊

笹原和俊

東京工業大学環境・社会理工学院准教授

1976年福島県生まれ。2005年東京大学大学院総合文化研究科修了。博士(学術)。専門は計算社会科学。主著に「フェイクニュースを科学する 拡散するデマ、陰謀論、プロパガンダのしくみ」(化学同人)、「ディープフェイクの衝撃 AI技術がもたらす破壊と創造」(PHP研究所)がある。

はじめに

現代社会においてデジタルプラットフォームは重要な役割を果たしている。TwitterやFacebook、InstagramやTikTokなどのSNSは、知人とのコミュニケーションだけでなく、様々なニュースや情報の発信と収集の主要ツールとなっている。しかし、SNSに流れている情報は真実ばかりとは限らない。デマ、陰謀論、意図的に操作された情報などの不確かな情報と確かな情報が混じりあい、情報環境汚染とも言える状況が生じている。

2016年のドナルド・トランプが勝利した米国大統領選では、フェイクニュースがSNS上に氾濫し、政治や社会を大きく混乱させた。広告収入が目当ての偽記事、選挙ビジネスや国家による情報操作の存在が一般に広く知られるようになったのはこの頃である。2021年1月には、トランプを英雄に祭り上げるQアノン信奉者たちが米連邦議事堂を襲撃する事件が生じた。この際、SNSなどのデジタルプラットフォームが扇動を助長したのではないかという意見もある。

2020年は、新型コロナウイルス感染症のパンデミックの発生にともない、再びフェイクニュースが氾濫した。反ワクチン言説だけでなく、「新型コロナのワクチンを人々に接種させ、監視用のマイクロチップを埋め込もうとしている」という陰謀論まで登場した。そして、パンデミックの収束が見えてきた2022年2月、ロシアによるウクライナへの軍事侵攻が始まった。SNSは現地の様子や重要な情報を伝える役割を果たしているが、国家のプロパガンダを拡散するのにも加担し、武器として使われている側面がある。

特定の目的を達成するために、SNSに不確かな情報を流して、人々を操作しようする不正行為を定量化し、その特徴を明らかにすることは、計算社会科学における重要な研究テーマである。計算社会科学とは、ビッグデータやコンピュータの活用が可能にするデジタル時代の社会科学である。本稿では関連研究を紹介し、デジタルプラットフォームの問題点やその対策について論じる。

Twitterボットによる偽情報の選択的拡散

偽情報の拡散は、ボットによる影響が無視できないほど大きくなっている。ボットがTwitter上で特定の候補者を支持する投稿を拡散したり、逆に特定の候補者を陥れるようなデマを拡散したりする動きは、2016年以降多く見られるようになった。2016年の米大統領選挙では、トランプ支持のツイートの方がクリントン支持のツイートよりも多く、その多くがボットによる自動投稿だったことが、オックスフォード大学インターネット研究所の調査で明らかにされている。

私の研究グループは、新型コロナウイルスに関するTwitterのデータを収集し、様々なトピックに関する投稿が、ボットによってどのように拡散されたのかを調査した[1]。まず、インディアナ大学が開発しているBotometerというツールを使用して、それらのアカウントがボットかどうかを判定した。そして、ジャーナリストが選定した信頼できるサイト(BBCなど)のリストと信頼できないサイト(Infowarsなど)のリストを参照して、前者の情報を主に投稿する普通のボットと、後者の情報ばかり投稿する悪質なボットを同定した。

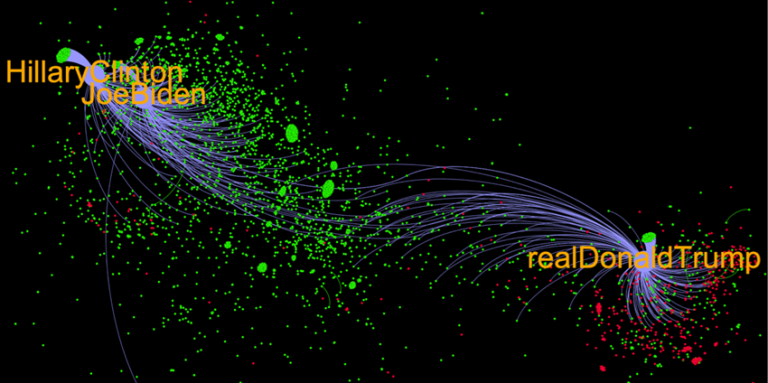

図1は分析結果の例で、コロナ禍初期におけるトランプの話題に関する投稿の拡散(リツイート)を可視化したものである。ノードは全てボットで、リンクはリツイートを表す。トランプ元大統領(@realDonaldTrump)とバイデン大統領(@JoeBiden)およびヒラリー・クリントン元国務長官(@HillaryClinton)のクラスター間の情報の流れが分離し、トランプの周辺に信頼できない情報を拡散する悪質なボット(赤)が多数存在していることが見てとれる。一方、バイデン大統領やクリントン元国務長官の周辺には、悪質なボットはあまり見られない(緑は通常のボット)。

2016年以降、Twitterはガイドラインを厳しくし、それを破ったアカウントの凍結を進めているが、高度化した悪質なボットは、トランプ元大統領周辺の不確かな情報を選択的に拡散していたことがわかった。2022年にTwitterの経営体制が変わり、今後、アカウントの管理やコンテンツ・モデレーションの方針が転換される可能性が大きいが、それは偽情報の生態系の構造に影響を与える可能性がある。

図1 偽情報を拡散するTwitterボット

ウクライナ侵攻とTelegram

Telegramはセキュリティとプライバシーに配慮されたチャットツールである。2022年2月のウクライナへの軍事侵攻以降、ロシアはTwitter、Facebook、Instagramなどの主要なSNSへのロシア国内からのアクセスを遮断した。ただし、Telegramは遮断の対象からは外れた。現在、ロシアとウクライナの双方にとって、Telegramは情報戦の武器として使用されている。

私の研究グループは、ロシア・ウクライナ戦争においてTelegramがどのように使われているかを知るために、ロシアの国営メディアRT(旧ロシア・トゥデイ)の公式チャンネル(@rt_russian)、ウクライナ政府の公式チャンネル(@UkraineNow)、ゼレンスキー大統領の個人チャンネル(@V_Zelenskiy_official)の3つに関して、データ分析を行なった[2]。

これらのチャンネルの登録数はオーダーの違いはなかった。投稿数で見ると、RTとUkraineNowが圧倒的に多く、V_Zelenskiy_officialの投稿数は最も少なかった。しかし閲覧数で見ると、ゼレンスキー大統領のチャンネルの閲覧数は桁違いに多かった。次に、これらのチャンネルの投稿の感情分析をしたところ、興味深い事実がわかった。投稿に含まれるテキストを非常にネガティブから非常にポジティブまでの5段階で評価したところ、RTとUkraineNowはややネガティブな方が相対的に多かったのに対して、ゼレンスキー大統領の投稿は、「thank」「freedom」「great」などの語を多用しており、不自然なほど最もポジティブな言語使用が多かった。

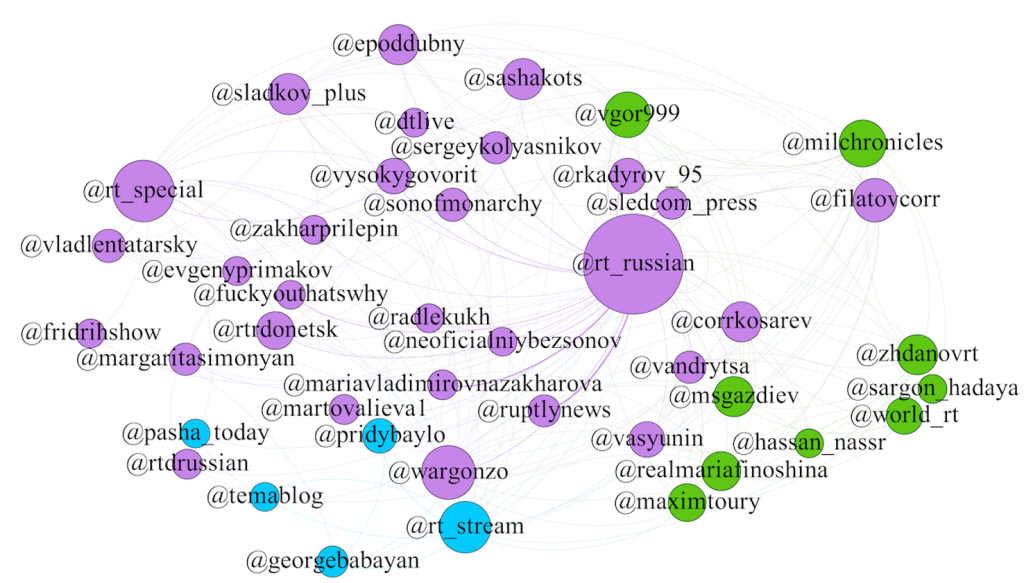

また、RTのチャンネルでは、意図的に情報拡散をしていることが疑われる結果が得られた。RTに返信したチャンネルの関係性を、メンションネットワークを構成して調べた(図2)。ノードはチャンネル、リンクはメンション関係を表す。このネットワークには、不自然なほどに「bot」という文字が入ったアカウントが見当たらず、ボットであることを隠してコミュニケーションに参加していることが疑われる。

これらの結果から、戦争中において、指導者がエンゲージメントを高めるためにSNSを利用したり、人のふりをしたボットが紛れ込むという危険性が示唆された。

図2 RTのメンションネットワーク

ディープフェイクと偽情報の高度化

ロシア・ウクライナ戦争では、偽情報の歴史において、もう1つ重大かつ深刻な事件が起きた。ロシアの軍事侵攻が本格化していく中、2022年3月、ゼレンスキー大統領が国民に武器を置いて降伏するように呼びかける動画が、ウクライナのニュースチャンネルのサイトで公開された。しかし、この動画のゼレンスキー大統領は、不自然に体の動きが少なく、声が本人よりも低いなど、すぐに偽動だと見抜ける程度のものだった。それでも、この偽動画はSNSで拡散した。この事態を受けてゼレンスキー大統領は、自らのインスタグラムの投稿で、この偽動画の内容を速やかに否定し、各種デジタルプラットフォームも直ちに投稿された動画を削除した。

偽ゼレンスキー大統領動画を作るのに使われた技術が「ディープフェイク」である。ディープフェイクとは、人工知能(AI)の技術を用いて合成されたリアルな画像、音声、映像のことである。ディープフェイク以前にも、真実を変えたり、歴史を書き換えるために視聴覚メディアの操作はプロパガンダの手法として使われていた。しかし、ディープフェイクは、それらとは比べ物にならない最先端の視聴覚メディア操作技術である。現在の主流の方法は、敵対的生成ネットワーク(GAN: Generative Adversarial Networks)と拡散モデル(Diffusion Model)の2つの方式である。生成AIと呼ばれる分野では、これらの手法の改良版が毎日のように発表され、生成されるコンテンツの質も量も格段に向上している。

それが可能になった理由は、膨大なデータをインターネットから取集し、ディープラーニング(深層学習)によって、モデルが自動で学習できるようになったことである。さらに、ディープフェイク技術がサービス化されたり、オープンソース化されたことにより、誰でも簡単かつ安価に画像、音声、映像を合成・生成できるようになった。ディープフェイク技術の民主化によって、フェイクメディアを使った印象操作や影響工作は、ますます高度化することが予想される。

2020年の米大統領選挙や2022年の米中間選挙では、ディープフェイクが蔓延して、選挙結果に影響を及ぼすことが警戒されていたが、幸いにしてそのような事態にはならなかった。しかし今のうちに、ディープフェイクなどの生成AIとそれがデジタルプラットフォーム上で出回るリスクに備える必要がある。

おわりに

AI技術の発展によって、ボットはさらに巧妙になり、ディープフェイクが真実を捻じ曲げ虚構を作り、SNSが偽情報を大量に拡散する未来は、ありうる世界線の延長上にある。悪意ある個人や国家がこれを黙って指を咥えているとは考えづらい。情報環境規模でこうした変化が起ころうとしている今、私たちには何ができるだろうか。ボットやディープフェイク、SNSの武器化に関して、ファクトチェックの活性化や情報リテラシーの向上は重要ではあるが、個人レベルの人力の取り組みだけでは限界がある。

私が最近着目しているのは、SNS上で機能するような「行動介入」である。例えば、GoogleのシンクタンクであるJigsawが、不確かなコンテンツによる被害を抑止するための行動介入の方法を紹介したウェブサイト「情報介入(Info Interventions)」を公開した[3]。いずれの方法も学術研究による根拠があり、プラットフォームのレベルでの効果が確認されたものだ。

そのうちの1つが、マサチューセッツ工科大学の研究グループが提案した「正確性のプロンプト(Accuracy Prompts)」である。同研究グループはSNSを模したシステム作り、実験の被験者に様々なコンテンツを提示した。そして、被験者が虚偽の可能性のあるコンテンツを目にした時に、閲覧を続ける前に「以下の投稿は誤解を招くもの、もしくは不正確なものでしょうか?」などのメッセージをシステム上のウィンドウに表示した。このようなコンテンツの正確性に注意を向けさせるような介入を行った結果、虚偽のコンテンツを共有する確率が減少し、その効果が持続することを実験的に示した[4]。この結果は複数の研究グループによって再現されている(ただし、少数ではあるが、国や文化によって再現できなかった例も報告されている)。こうしたシステムレベルでスケーラブルな行動介入は、偽情報の拡散を抑制することが期待できる。

また、ディープフェイクの脅威に対抗するための研究も進められている。私も関わってっているCREST FakeMediaは、AIによって生成された高度なフェイクメディアがもたらす潜在的な脅威に対処する情報技術を確立することを目指している。このプロジェクトでは、AIによって生成されるフェイクメディアとして、「メディアクローン型」(本物に限りなく近いが本物ではないもの)、「プロパガンダ型」(世論操作や印象操作を目的として意図的に編集されたもの)、「敵対的サンプル」(人間には識別困難だが、AIを誤動作させるもの)の3つを想定して、これらを生成する技術や検出する技術を開発している。私の研究グループでは、これらの技術を用いて意思決定の補助情報を提示するシステムを構築し、大規模なオンライン行動実験によって検証することを目指している。すでに多くの研究成果が生まれてており、社会実装に向けて検討が進んでいるディープフェイク検出技術も開発されている。

偽情報の生成と抑止の研究はいたちごっこの様相を呈しているが、ボット、SNS、ディープフェイクがデジタルプラットフォームに氾濫し、情報環境のさらなる汚染が進む前に、計算社会科学による実態解明と対策を今検討する必要がある。

[1]Xu, W. & Sasahara, K. Characterizing the roles of bots on Twitter during the COVID-19 infodemic. J Comput Soc Sc 5, 591–609 (2022).

[2]Ghasiya, P. & Sasahara, K. Messaging Strategies of Ukraine and Russia on Telegram during the 2022 Russian invasion of Ukraine. (2022) doi:10.21203/rs.3.rs-2288409/v2.

[3]Info Interventions. Info Interventions https://interventions.withgoogle.com/.

[4]Pennycook, G. et al. Shifting attention to accuracy can reduce misinformation online. Nature 592, 590–595 (2021).